CoT并非LLM标配!三大学府机构联手证实CoT仅在数学符号推理有用

CoT:思维的拐杖,还是推理的翅膀?

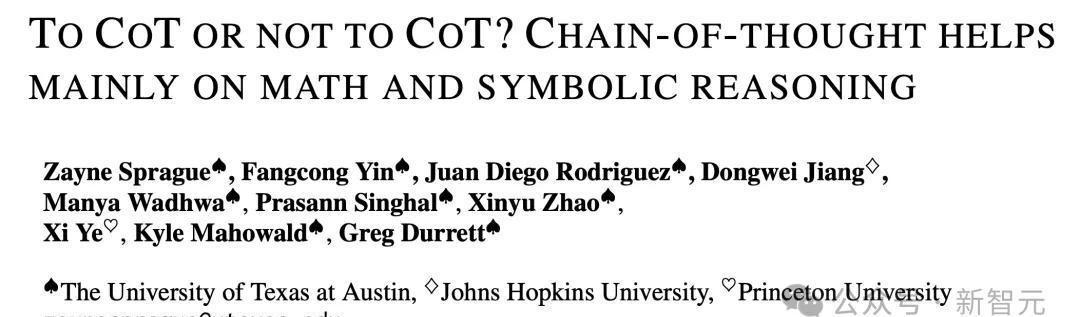

“CoT并非LLM标配!” 这句断言,如同一记重锤,敲击着人们对大型语言模型 (LLM) 的固有认知。CoT,即思维链 (Chain of Thought),曾被寄予厚望,被视为赋予LLM 复杂推理能力的利器。来自UT-Austin、霍普金斯、普林斯顿三大机构的联合研究却揭示了一个令人深思的结论:CoT 并非万能灵药,其效用存在着明显的边界。

CoT:思维的拐杖?

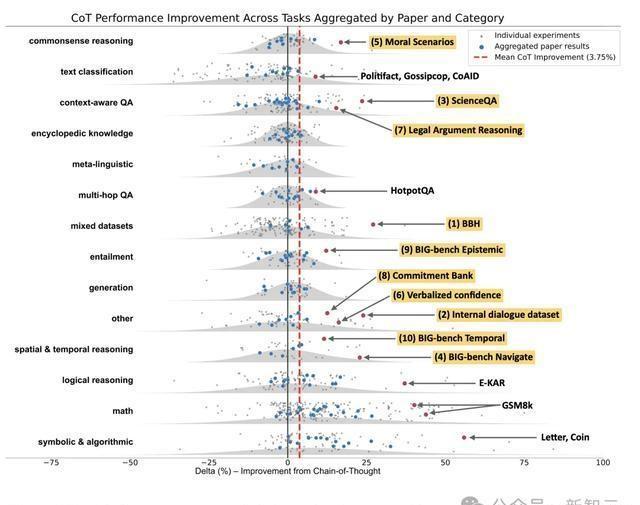

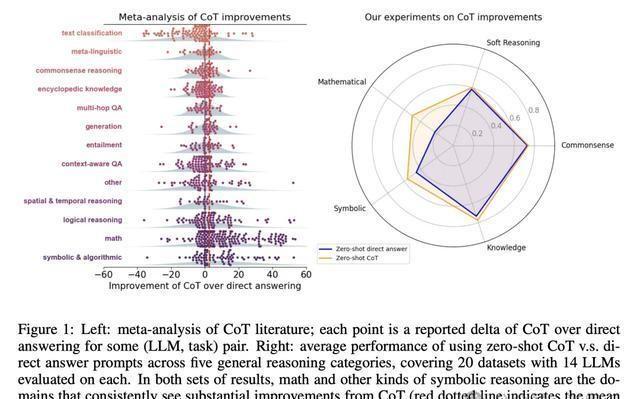

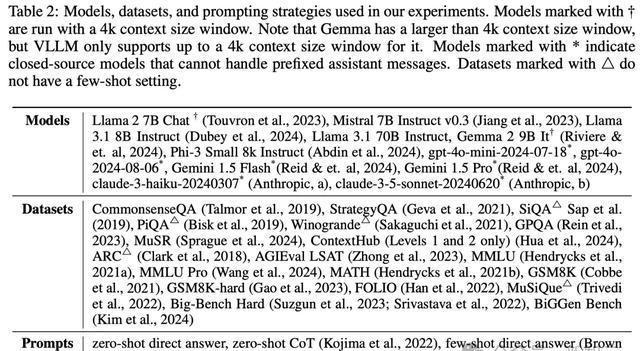

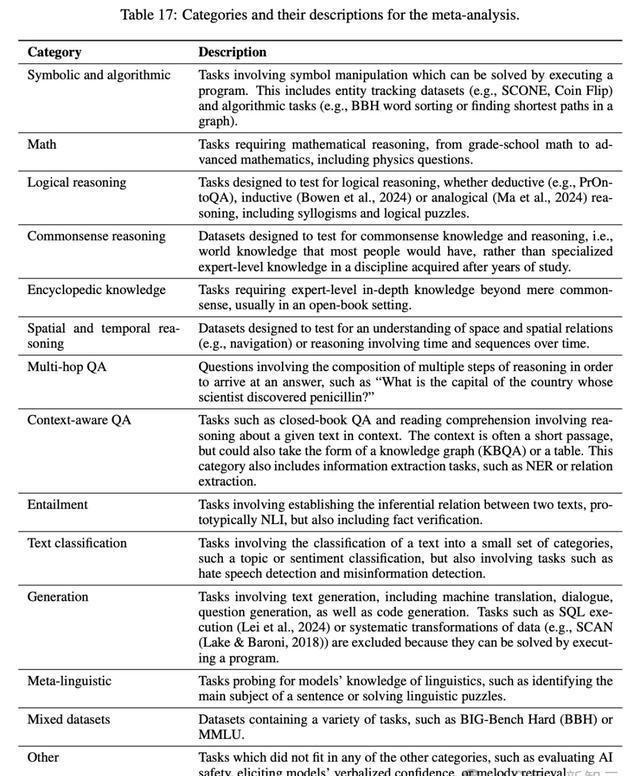

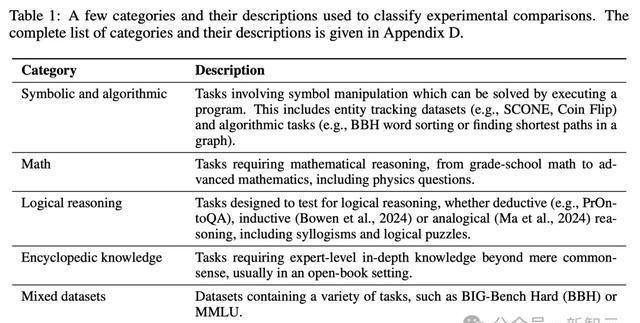

这项研究对 CoT 的有效性进行了迄今为止最为全面和深入的分析。研究人员通过对 100 多篇论文和 14 类任务进行元分析,发现 CoT 仅在涉及数学和符号推理的任务中表现出色,而在其他领域,其作用微乎其微,甚至可能适得其反。

这一发现挑战了 CoT 作为 LLM 标准配置的观念。CoT 更像是辅助 LLM 进行特定类型推理的“拐杖”,而非赋予其全面推理能力的“翅膀”。它在处理结构化、逻辑性强的任务时表现优异,例如数学题或逻辑推理题。当面对需要常识、语义理解、情感分析等更为主观和复杂的推理任务时,CoT 却显得力不从心。

为何 CoT 会“偏科”?

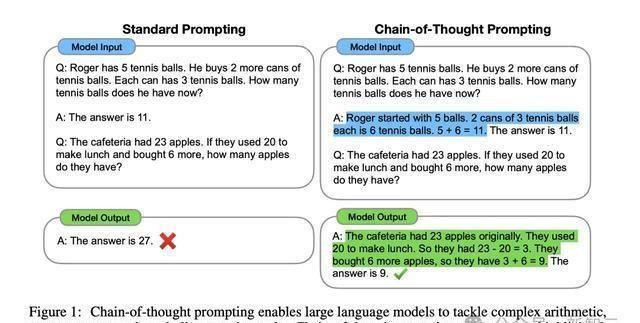

CoT 的局限性源于其自身机制。CoT 通过将复杂问题分解为一系列简单的步骤,引导 LLM 进行逐步推理。这种方法在处理结构化问题时非常有效,因为这些问题的解题思路通常可以被清晰地分解。

现实世界中的许多问题并非如此。例如,理解一句讽刺的话语,需要结合语境、语气、文化背景等多方面因素进行综合判断,而这些因素难以被简单地分解成步骤。

超越 CoT:探索 LLM 推理能力的新疆域

CoT 的局限性并不意味着 LLM 无法获得更强大的推理能力。相反,它指引我们应该探索更具突破性的方法,例如:

整合外部知识库:

将 LLM 与包含常识、专业知识、文化背景等信息的外部知识库相结合,可以弥补 LLM 在这些方面的不足,使其能够更好地理解和处理复杂问题。

模拟人类认知过程:

人类的推理过程并非简单的线性推理,而是包含直觉、联想、类比等多种认知方式。未来的 LLM 可以借鉴人类认知机制,发展出更灵活、更强大的推理能力。

强化学习与元学习:

通过强化学习和元学习, LLM 可以从大量数据中学习到更有效的推理策略,并根据不同的任务类型自动调整推理方式。

CoT:从工具到启示

CoT 的出现,并非仅仅是一种技术工具的革新,更是一种对人工智能发展方向的启示。它提醒我们,仅仅依靠扩大模型规模和数据量,并不能真正实现通用人工智能的目标。

未来的 LLM 需要具备更强大的推理能力、更灵活的认知方式、更深入的知识理解,才能真正突破现有瓶颈,迈向更加智能的未来。

相关文章:

正泰指纹锁客服人工电话(全国统一)400客服热线实时反馈全+境+到+达04-05

ADIMO保险柜维修售后号码24小时丨全国400服务点实时反馈全+境+到+达04-05

水花消失术×2,全红婵、陈芋汐单人跳也能“神同步”04-05

锢力保保险柜维修售后号码24小时丨全国400服务点实时反馈全+境+到+达04-05

湖北昊和轨道交通取得一种桥梁检查车专利,结构设计合理操作方便04-05

“你好!中国”吉林省文旅推介会在瑞士举行04-05